热线电话:400-882-3320

方案简介

观测云通过开源组件 OpenLIT 和 OpenTelemetry,为基于大模型(LLM)语言开发的智能体提供统一的日志、指标和链路追踪数据采集与实时监控解决方案。帮助团队深度洞察模型推理性能、成本与异常,快速定位瓶颈并持续优化。

场景挑战

LLM 推理过程黑盒,决策过程无从监控

请求和应用调用链路复杂

LLM 成本难控,调用可能产生高额费用

观测云方案

完整请求/令牌(Tokens)可视化,精准量化成本与复杂度

按应用与模型分类的调用量与时长分析,一目了然

链路追踪(Trace)与火焰图,快速锁定慢请求与错误链路

方案亮点

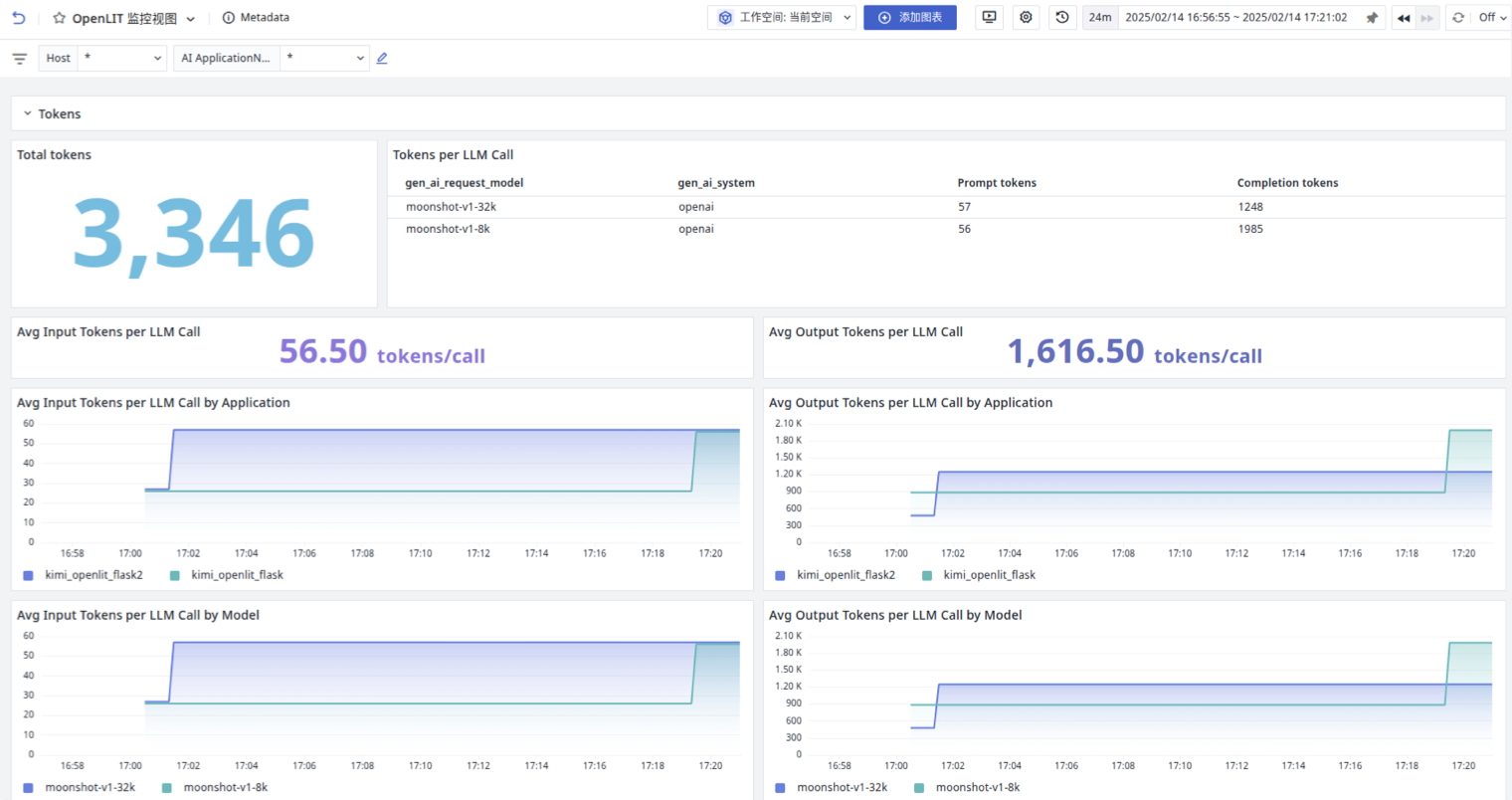

Token 与请求量可视化监控

您将看到一个实时更新的大盘,清晰展示整体消耗的 Total Tokens 以及 Prompt Tokens 与 Completion Tokens 的比例,并能按模型和应用维度细分平均 Input/Output Tokens。通过这种全景式的监控,团队可以在开发阶段即刻评估每次调用的成本与复杂度,避免上线后因意外高耗导致账单激增;系统还支持为异常 Token 波动设置阈值,一旦某次请求超出预期范围,立刻触发告警,帮助您随时掌握成本动向。

立即监控 SAP

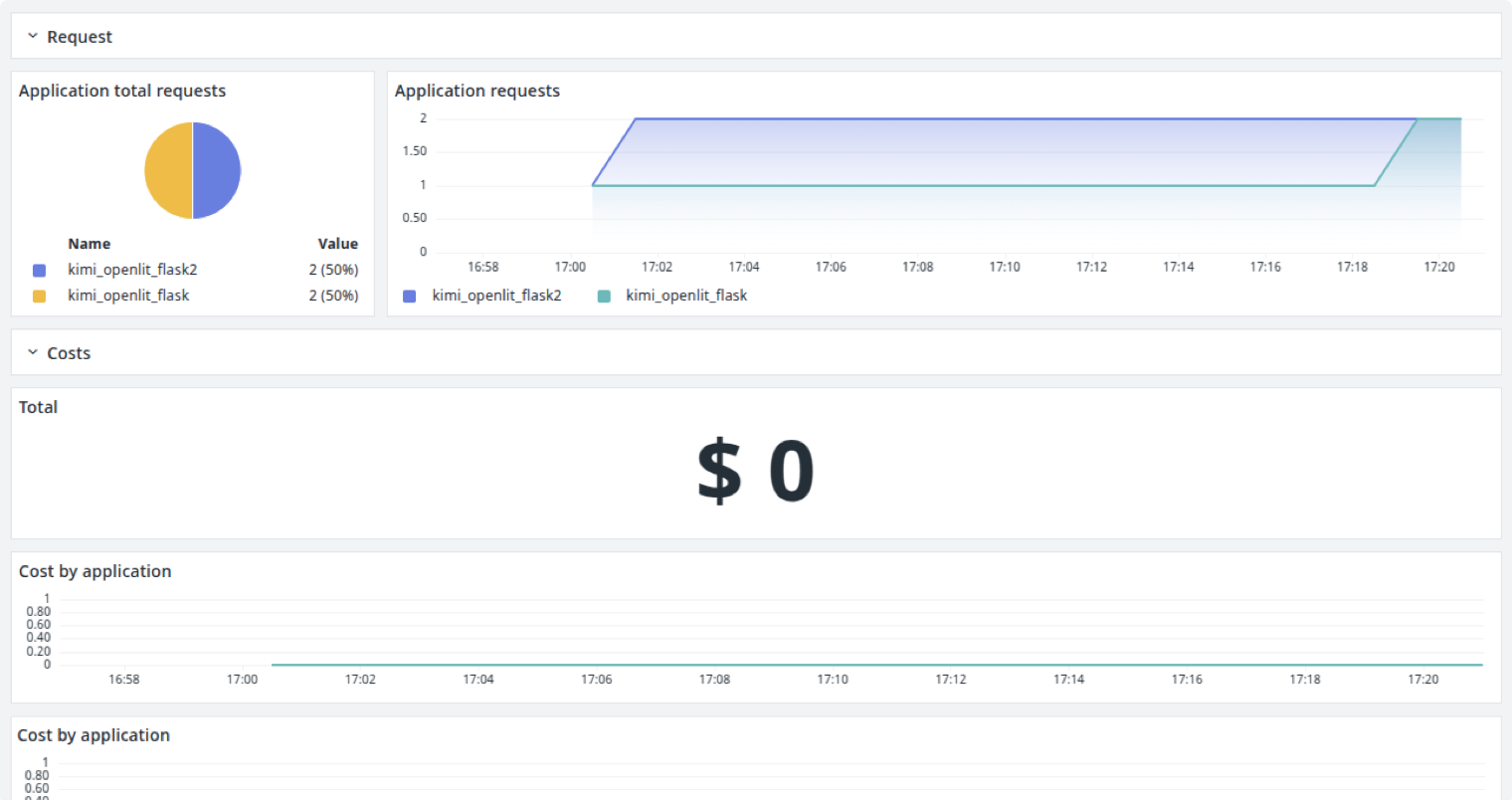

成本与趋势分析

所有 LLM API 调用次数、平均单次费用及累计消耗都可以汇聚到一张图表中。借助趋势折线,您可以清晰洞察调用量和费用走向,帮助产品和财务团队精准制定预算;同时,当某个维度的成本或请求量触及设定阈值时,平台将即时提醒,避免潜在的流量激增导致预算超支,为您的规模化部署保驾护航。

立即监控 SAP

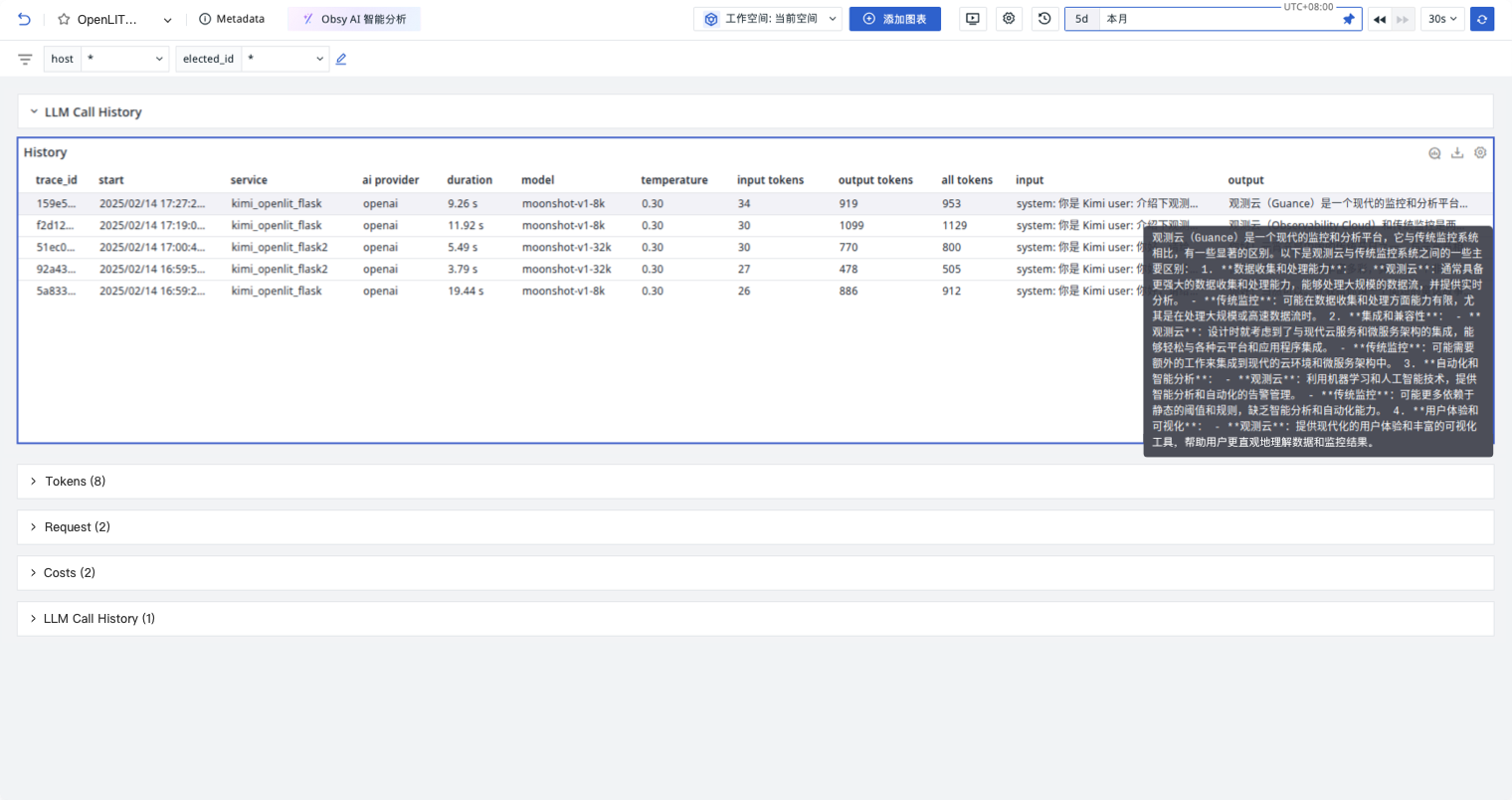

LLM 调用链路历史

在 “LLM 调用链路历史” 中,您可以通过 Trace ID 快速回溯每一次推理请求的完整元数据,包括开始与结束时间、实际选用的模型版本、temperature 参数、prompt 长度以及输出摘要等。该功能不仅能一键筛选出失败或超时调用,还可结合输入输出日志进行深度排查,帮助开发与运维团队迅速复现问题;同时支持将历史记录导出为 CSV 或 JSON 格式,便于跨部门共享与分析。

立即监控 SAP

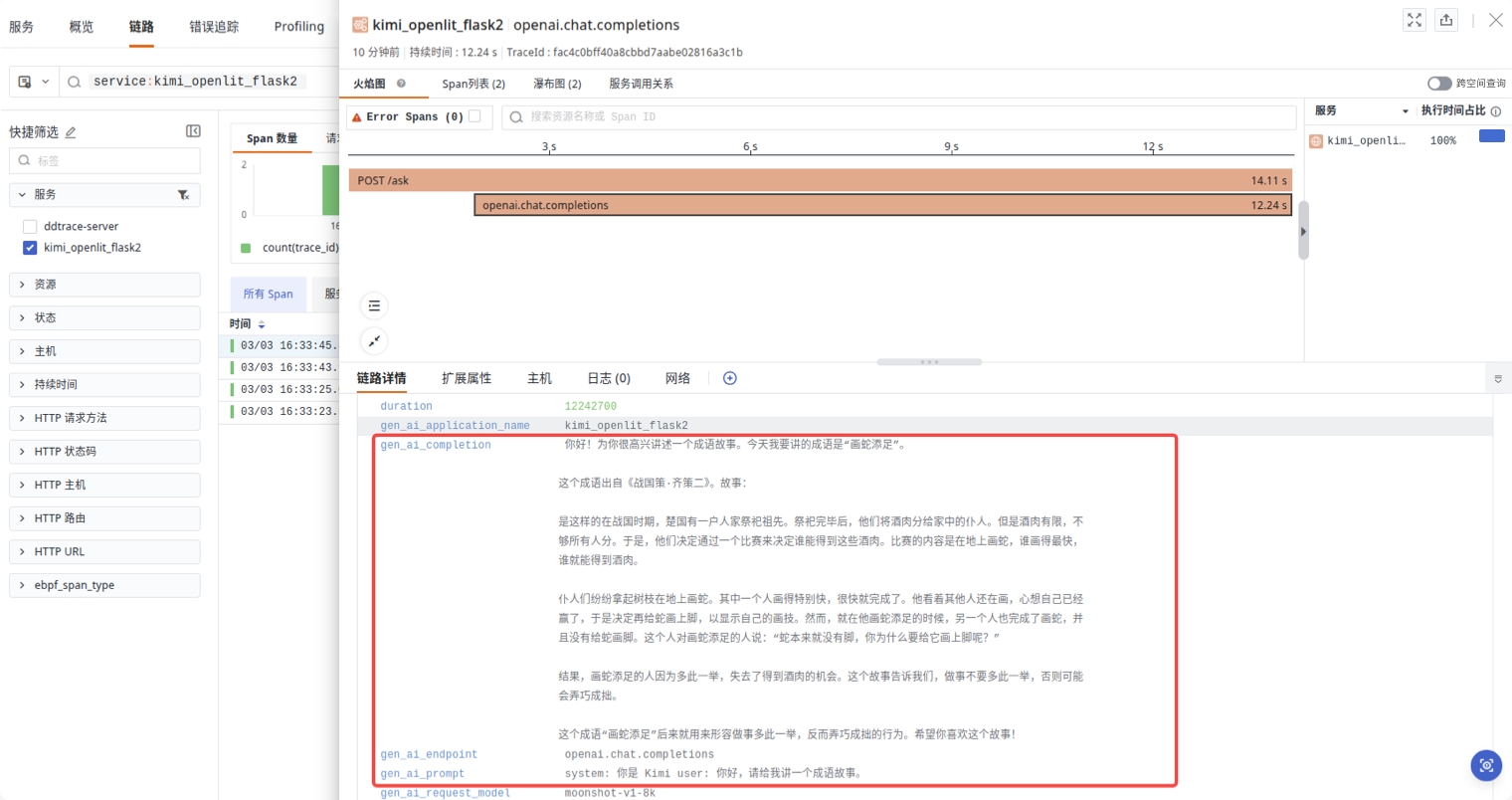

火焰图与根因分析

“火焰图与根因分析”模块在链路详情页中自动渲染子 Span 的耗时分布,您可直观识别哪些调用阶段最耗时,并结合 P75、P90、P99 等响应时长曲线深入挖掘偶发慢请求的根本原因。找到瓶颈后,还能一键跳转至相应代码或配置界面,帮助团队在同一平台内完成性能诊断与优化闭环。

立即监控 SAP

更多内容